Quand la prévision traditionnelle atteint ses limites : une approche pratique des prédictions tenant compte du contexte

Becks Simpson

Introduction

La prévision dans le domaine de la santé ne suit pas de règle stricte. Une mesure peut réagir à des interventions ciblées par des sauts soudains, tandis qu’une autre affiche des améliorations progressives liées à la gestion des soins sur le long terme. Les prédire nécessite de comprendre le contexte qui les motive, pas seulement les données historiques. Nous avons rencontré ce défi lors du développement de prévisions pour des indicateurs de qualité de soins. Les méthodes traditionnelles semblaient fiables sur le papier, mais elles se sont effondrées face à la complexité du monde réel.

Corps

L’impasse de la prévision traditionnelle

L’approche initiale paraissait simple : utiliser des modèles ARIMA en Python pour la prévision des séries temporelles. Ces modèles statistiques conviennent à de nombreuses applications, mais les indicateurs de santé introduisent des complications. Chaque modèle demandait des ajustements de paramètres. L’infrastructure de déploiement exigeait un important travail d’ingénierie. Plus crucial encore, mettre ces modèles en production aurait consommé des ressources précieuses ailleurs.

Nous avons pivoté pour les modèles de séries temporelles de Snowflake, qui intègrent de nombreuses bonnes pratiques de prévision. Les résultats étaient raisonnables selon les métriques classiques—MAE, RMSE et MAPE étaient acceptables. Mais quand les experts métier ont examiné les prédictions, quelque chose clochait. Les prévisions n’étaient pas en phase avec leur compréhension du comportement réel de ces mesures.

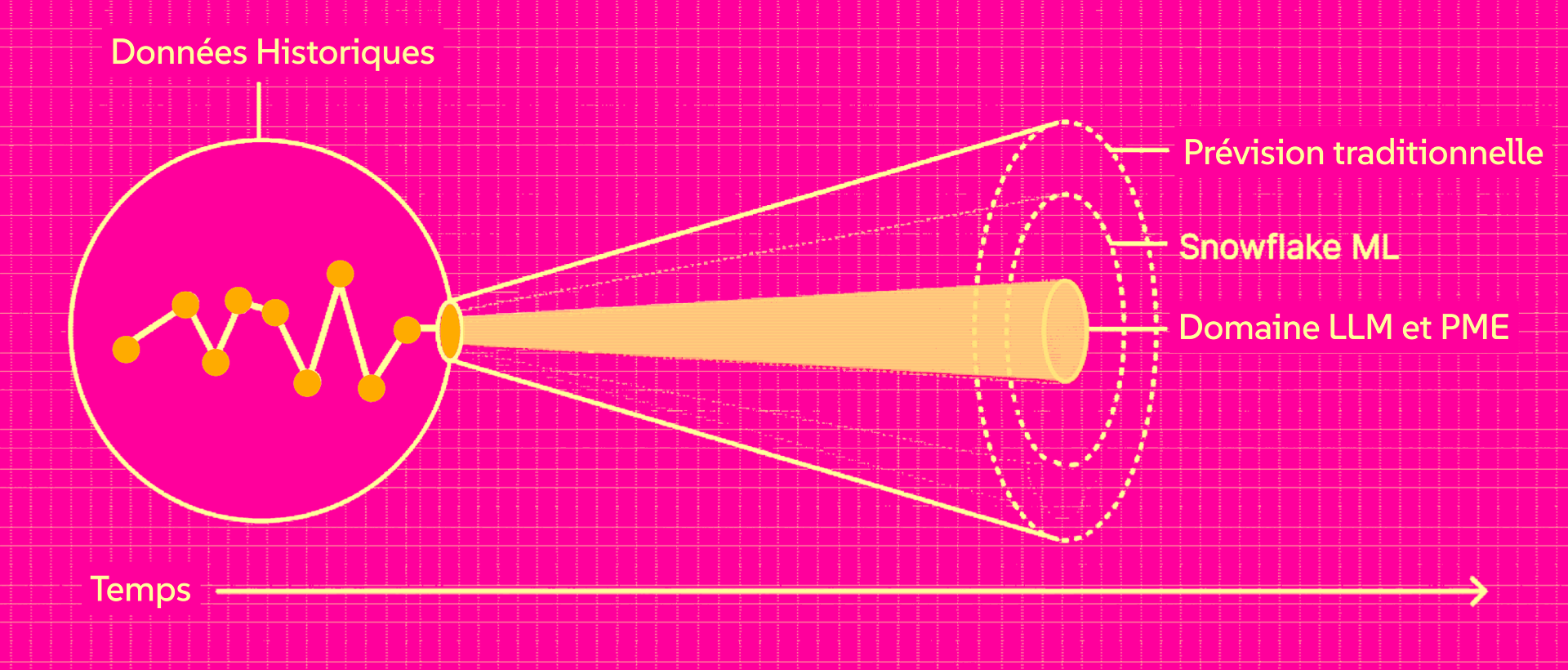

Cette déconnexion a révélé le problème central : les modèles statistiques apprennent uniquement à partir des données historiques. Ils ne savent pas intégrer la connaissance métier sur les schémas saisonniers, le calendrier des interventions, ou les contraintes opérationnelles que les experts connaissent mais qui n’apparaissent pas dans les chiffres.

Le contexte change tout

La solution s’est révélée plus simple qu’attendu. Au lieu de modéliser statistiquement de manière plus sophistiquée, nous avons eu recours à des grands modèles de langage conçus pour le raisonnement avancé. Avec Gemini et des prompts préformatés, nous avons construit un outil de prévision tenant compte du contexte, combinant données historiques et connaissance métier explicite.

L’approche fonctionne ainsi : pour chaque prédiction, le modèle reçoit l’historique numérique ainsi qu’un bref résumé du contexte pertinent—des éléments comme « les campagnes de dépistage annuelles entraînent généralement une augmentation de 15 % au quatrième trimestre », « l’adhésion au traitement commence forte mais décroît à la fin de l’année » ou « le plan a engagé un prestataire pour renforcer la conformité au dépistage des maladies oculaires, ce qui devrait augmenter le score de 5 à 10 % ». Le modèle concilie ce que montrent les données et ce que nous savons des dynamiques réelles et des facteurs externes actifs au moment de la prédiction.

Les experts métier ont immédiatement préféré ces prévisions. Les prédictions respectaient à la fois les tendances historiques et les règles complexes expliquant la variation des scores. Quand la prévision montrait un bond en octobre, ce n’était pas parce que l’algorithme identifiait un motif ; c’était parce que le modèle savait que c’est à ce moment que l’intervention a lieu.

Cela rejoint ce que nous observons plus largement en IA appliquée. La solution la plus pertinente est souvent celle qui colle à la réalité du domaine, pas nécessairement l’algorithme le plus complexe.

Quand utiliser la prévision contextuelle

Cette approche est idéale lorsque :

- La connaissance métier affecte fortement les résultats mais n’est pas toujours visible dans les données

- Les experts peuvent formuler des règles, contraintes et facteurs explicatifs

- Les données historiques sont limitées ou comportent des anomalies expliquées

- L’interprétabilité est cruciale—les parties prenantes doivent comprendre l’origine de la prédiction

Elle est moins appropriée lorsque :

- On dispose d’un large historique très stable

- Les facteurs extérieurs ont peu d’impact ou sont déjà inclus dans les données

- Les contraintes de coût et de latence sont majeures

La prévision contextuelle par LLM peut échouer plus fortement que les modèles statistiques traditionnels—les prédictions peuvent dépasser largement la réalité, donc il est important d’ajouter des garde-fous et des contraintes. Une approche de type "ensemble" peut aussi aider. En combinant une base statistique solide avec la prévision contextuelle, on limite le risque tout en tirant parti de la connaissance métier.

Résumé

Le parcours allant d’ARIMA aux modèles Snowflake puis à la prévision par LLM n’a pas été une évolution linéaire vers une méthode « meilleure ». Chaque approche présente des compromis. Les modèles statistiques traditionnels garantissent leur fiabilité et une interprétation fondée sur les mathématiques. La prévision basée sur LLM permet d’encoder une logique métier complexe que les données seules ne peuvent refléter.

L’essentiel à retenir : lorsque la prévision repose sur des relations causales claires et des règles explicites—pas uniquement des séries historiques—les méthodes tenant compte du contexte font le lien entre ce que montrent les données et ce que savent les experts métier.

Pour les organisations envisageant cette approche, commencez par des domaines où l’intuition des experts est forte sur les leviers d’action. Concevez des prompts qui captent systématiquement cette expertise. Et soyez honnête sur les contraintes de mesure—parfois « validé par les utilisateurs » est le critère qui compte vraiment, même s’il ne correspond pas à celui qu’on aimerait publier.